拡大画像とピクセルサイズ

拡大画像って?

拡大画像について説明します。拡大画像を得るためには何をどうしてるのでしょうか?

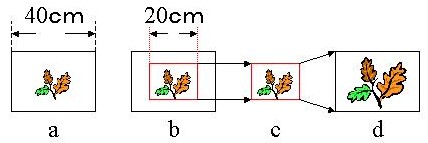

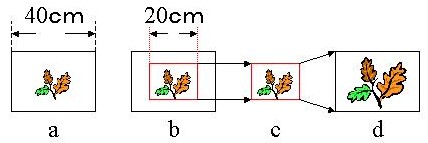

はじめに128×128の1倍拡大と2倍拡大の話をします。私たちが2倍拡大画像を得るためには下の図のように検出器の一部を使っておこないます。

検出器の大きさが横が40cmだとします。a図のように葉の画像は横40cmの検出器で得られた画像です。これを2倍拡大するのは収集するる横の長さを20cm(面積 では1/4)として画像を作り出せばc図の画像ができます。

でも、a図とc図を比較してみてください。葉の大きさは同じです。拡大にはなっていません。では、a、c図をパソコンに表示させてみましょう。

ドットとピクセルはどのように違うの?

a、c図をパソコンに表示させる前に、パソコンCRTディスプレーの解像度について考えてみます。

仕事で使っているパソコン(17インチ)のCRTディスプレーの標準表示仕様を説明書で調べてみました。

| 解像度 | 表示寸法 |

| 1024×768ドット | 320mm×240mm |

表示寸法はCRTの大きさのことで横320mm、縦240mmの画面のことです。解像度・・・・ドット?・・・ドットじゃなくてピクセルではないの?

こんな疑問が浮かんできませんか?スキャナで画像を取りこむとき100dpi(dots

per inch)の言葉を耳にします。これが解像度なのです。ではここで解像度として表している1024×768ドットは何を意味するのでしょうか?

どうしてか知りませんがディスプレのスペックを表現するときには、dpiではなくドットが使われています。本体ならデジカメのような出力画素数と呼ぶべきだったのかもしれません。では、ドット=ピクセル?? ドットとピクセルとの違い?

1. 昔のWindowsではドットと呼んでいた。

2. Windows95からピクセルと言う呼び名が出てきた。

昔のパソコンは白黒の画像でした。白黒をパソコンで表すには0〜255の256段階でモノクロ画像としてきました。256=8bit画像です。画像はこれだけの表現しかありませんでした。パソコンがカラーを表示するようになるとフルカラーでは24bitとなりました。8bit×3です。ですから、昔は色は8bitのみのモノクロ画像でしたから点の数(ドット)のみで表現できたのですが、色がカラーに変化することで「色」を表現することが必要になってきました。したがって、ドットがピクセルという呼び名になったのだと思います。

a、c図をパソコンに表示させてみましょう!

a図は400mmの長さを128分割しています。400mm÷128分割=3.125mm間隔でデータを取っていっています。

c図では200mmの長さを128分割しています。200mm÷128=1.5625mm間隔です。2倍拡大の方が密となっています。

これをパソコンに表示することを考えます。もう一度パソコン画面17インチの解像度を記述します。

| 解像度 | 表示寸法 |

| 1024×768ドット | 320mm×240mm |

パソコンのドットは上の表のようですから、横方向は320mm÷1024分割=0.3125mm間隔に点が表示できるようになっています。縦方向も

240mm÷768分割=0.3125mm間隔で点が表示できるようになっていますから、a図の3.125mm間隔で取ってきた128個のドットは、パソコンでは、0.3125mm間隔の128個のドットとして表示されます。同じように、c図の1.5625mm間隔で取ってきた128個のドットもパソコン上ではa図とおなじように0.3125mm間隔の128個のドットとして表示されますから、パソコンに表示すると表示される面積はa図=c図となり画像は拡大されと同じ事になります。

先の解像度の話のなかでdpiがでてたきました。パソコンの「1024×768ドット、320mm×240mm」をdpi表現してみましょう。

dpiは1インチあたりのドット数ですから、

1インチ=2.54cm=25.4mmとなります。dpiとは25.4mmあたり何ドットあるかを表現したものになりますから、パソコンの表示画面は横方向320mmに1024ドット、縦方向は768ドットですので、dpiを求めるには、25.4mmあたりに何ドットかを計算すればよいことになります。したがって

横方向では 320mm : 1024ドット=25.4mm : 横は何ドット

横は何ドット = (1024×25.4)/320 = 81.28ドット

縦方向は 240mm : 768ドット = 25.4mm : 縦は何ドット

縦は何ドット = (768×25.4)/240 = 81.28ドット

となり、画像解像度は約85dpi程度となっていることがわかります。

(解像度はdpiもありますが、ppi(pixcel per inch)と表現されることもあります。一般にdpiは画像入出力機器のスペックを表しています。ppiは画像データの解像度を表すもので画像解像度と呼ばれています。)

128×128で2倍拡大?

128×128・・・・・話を簡単にするために上の検出器の大きさを正方形であると仮定します。横40cm、縦40cmの検出器です。この検出器で100×100ピクセルの画像を収集します。すると、収集するときのピクセルサイズを計算します。ピクセルサイズとは1ピクセルの長さのです。

40cmを100分割ですから、1ピクセルの長さは(400mm/100)=4mmとなります。4mm×4mmが1ピクセルのおおきさです。

2倍拡大してみます。2倍拡大は検出器の半分の長さを使っていますから、横20cm、縦20cmの検出器を使用してることになります。ですから128×128で2倍拡大とは、この20cm×20cmの領域を横縦100分割することですから、1ピクセルの長さは(200mm/100)=2mmとなり、1倍拡大に比べて収集する1ピクセルは半分の長さになります。それだけ細かく収集してることになります。

したがって、同じものを同じ時間で収集すると2倍拡大はピクセルサイズが半分になっているため、2倍拡大ではノイズが目立つことになりますから、一般的には2倍拡大をするときには収集時間を増やす必要があるのです。

128×128と64×64画像の比較について

最上段のa図で説明します。128は40cmを128分割ですから(400mm/128分割=)3.125mm間隔でデータを収集したことになります。

64は400mmを64分割(6.25mm)で収集したことです。1ピクセルの大きさは64の方がおおきくなることは当然のことです。

この収集した画像をパソコンに単純に表示したとしたら、パソコンの画面は、25.4mmに約85ドットの点のあるまりですから、128×128を表示すれば、パソコンの画面で128ドット×128ドットを使用して画像が表示されますし、64×64では64ドット×64ドットの点の集まりとして表示され、ピクセルのおおきさは反映されません。64は小さく、128は大きく表示されるだけです。

しかし、表示する場合には、128も64も同じ面積(大きさ)で表示されないと困ります。これらは装置がもっている画像の表示方法(ソフト)によって表示されますから、64の画像は128と同じ面積まで引き伸ばせば(64での1ドットを2×2ドットで表示させるようにすれば)128と同じ大きさで比較でき、しかも1ドットの大きさも2×2ドットの大きさになりますからピクセルも粗くなったように表示できるのです。